お手軽にドローンの練習をしたい

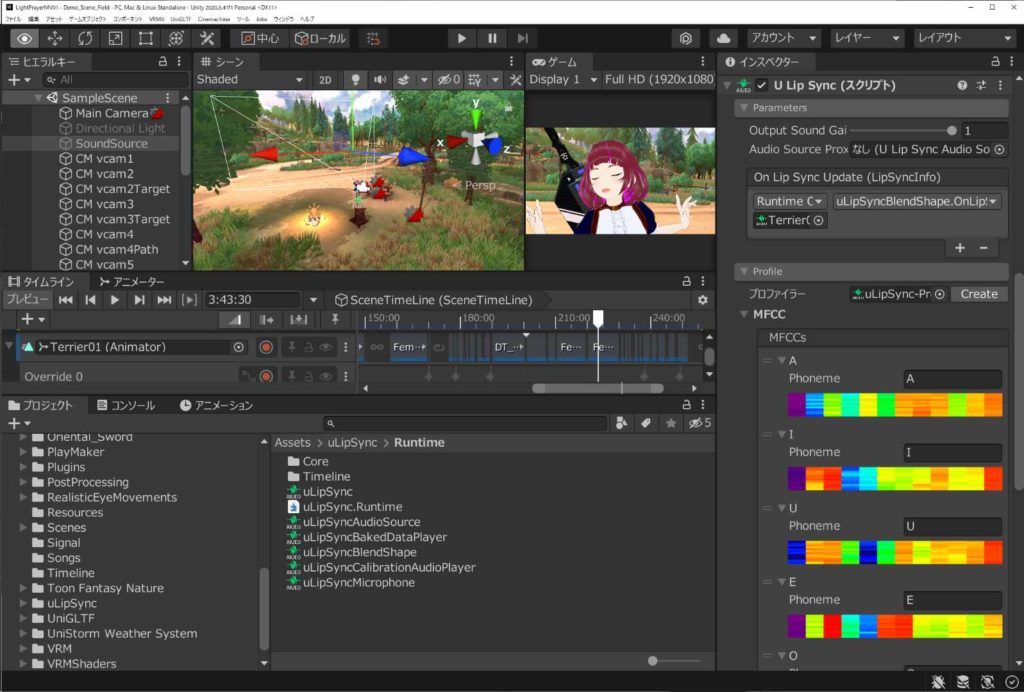

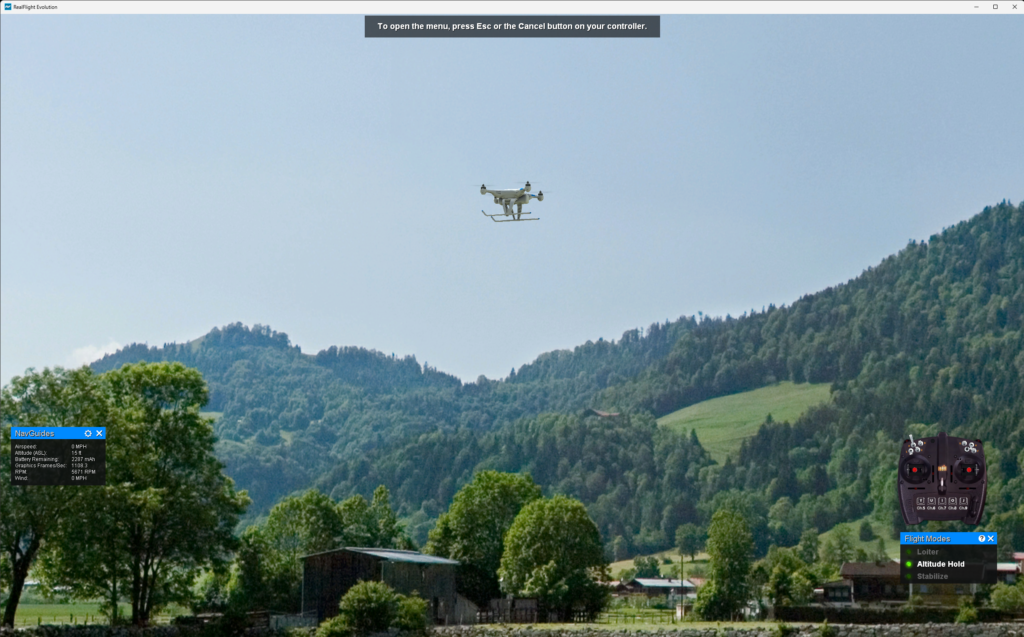

ドローン買ったはいいけど、飛ばすには色々準備も必要だし、夏も真っ盛りでクソ暑いし、練習したいけどどうしよ…と考えていた時に見掛けたのがRealFilght EvolutionというPC向けのシミュレーターソフトでした。

Steamを覗いていてもドローンのゲーム等は割と出てくるのですが、どれもFPV用ドローンのゲームでそれはそれで面白いのだと思うのですが、いかんせんコックピット視点なので空撮ドローンを目視で飛ばした時のような操作(向き合うと左右が逆になる等)の練習にはなりません。

なので、色々探しては見たのですが、おそらく唯一?ラジコン操縦者の視点で操作出来るソフトがこのRealFlight Evolutionでした。歴史も古いようで、元々はラジコン飛行機やヘリコプターのシミュレーターだった所にドローンも扱えるようになったようです。シミュレートが主なので練習モードとか課題クリアのモードはあるにはありますが、いわゆるゲームした感じではないので練習用と割り切るべきでしょうか。

ソフト自体はパッケージ版とダウンロード版があって、自分はSteamで買いました。日本円で16000円と中々良いお値段するのですが、練習用には唯一無二の存在とあって選択の余地もなく…といった感じでしょうか。

先にも書いた通り、元々はラジコン飛行機やヘリコプターが主で、ドローンは後から追加された歴史のようなので使える機種もドローンはあまり多くは無いようです。ただ、Quadcopter Xという機種が選べまして、これがDJIのPhantomに似た感じの機体で、練習にはこれで充分かなと思います。

ステージはかなり豊富にあって、室内や強風の吹いてるステージとかありました。ただ、室内とかやると分かるのですが、全体的に遠景はリアルではありますが、向いている方向によってパースがかかる感じでも無いのでおそらく書き割りで、そこに小道具のちょっとした柵だったり小屋や岩が少し衝突判定用のコリジョンを用意しているのかな、という印象です。

なので、ゲーム視点で見ると今時…?と思う所もあります。ただ、ドローンの操縦の練習という観点で考えると、目視内飛行の練習という意味ではこれらは特に問題にはならず、逆に上記の仕組み上、ドローンからの視点の映像は作れませんので、カメラを見ながら操作する目視外飛行の練習は出来ないという課題は残るのかな、と思います。

練習に使うコントローラーは

RealFilght EvolutionはDirect InputやXInputに対応しているらしく、当初は自分もPS5のDualSenseをPC繋いでいたのでそれで練習していました。

で、やってて気付いたのですが、操作感が違うんですよね…。ゲームのコントローラーってスティックの入力範囲が中心から一定距離を保つ円状にしか物理的に動かせないようになってますけど、ドローン用のプロポの場合、横軸と縦軸どちらもMIN/MAXで入力する可能性があるので可動範囲は四角形なんですよね。

この辺に対して、RealFlight Evolutionではまんまプロポの形したInterLinkDXというUSB接続型のコントローラーのバンドル版を用意してたり(単体でも購入可能)、プロポで有名な双葉電子では自社のプロポで操作可能になるUSB接続のドングル(受信機)「WSC-1」を販売していたりします。

ただ、InterLinkDXにしてもWSC-1を経由した双葉電子のプロポにしても、ラジコン飛行機やヘリ用のプロポの形をしているのでスイッチ類がやたらと多い&中々高価という事もあってどうしたものかなーと思いつつ、代替案をしばらく探してました。

そんな中見つかったのが、いつもお世話になっているDJIから出ているDJI FPV送信機3でした。

FPV送信機3がRealFlight Evolutionで使えた

ネットで記事を漁っている時にFPV送信機3をUSBで接続するとWindowsではゲームコントローラーとして認識するという話を見掛けまして、DJIのサイトで詳しく見てみると、色々スペックが書いてある中に「2.DJI FPV 送信機 3は、Liftoff、Uncrashed、DCL、The Drone Racing Leagueなどを含む、様々なシミュレーターに対応しています。」との表記が。

RealFlight Evolutionの名前はありませんでしたが、挙がっていたゲームをそれぞれSteamで確認するとまぁDirectInputとかXInputで操作出来るゲームかな、という感じだったのでたぶんイケるだろう…という事で購入してみました。まぁ、もしダメでも最近出たNEOとかAvata2に対応してるので将来使えるかもしれないし(怒られる)。

という訳でポイント溜まってたヨドバシさんが速攻で持って来てくれまして、早速USBケーブルで接続して試してみた所、最初認識しなくて青ざめましたが、よく考えればこれは送信機なのでDJIのいつもの儀式が必要なんじゃないかと気付きました。

電源ボタンをトントーーーン(長押し)とすると、あっさりWindows側でも認識しました(^^;。

RealFlight Evolutionを起動して、左右4軸をなんとなく認識してしまえばこちらのもので、後は新しいコントローラセッティング作って、各操作の項目で割り当てたいスティック倒してあげればそのまま記憶してくれました。操作したいのがモード1なのかモード2なのかで割り当て変わってくる感じですかね…?

割り当てが無事済んで操作してみると、うん、いつものDJIの操作感ですね(そりゃそうなんだけど)。ちゃんと四角形の範囲で操作出来て違和感は無くなりました。金属製の長いレバーもやはり操作しやすいですね。

若干気になったのはPS5のコントローラーで練習していた時に比べると微妙に最高速度上がった?という印象を受けました。今までコントローラの設定悪くてMAXまで入力出来ていなかったんでしょうか…?

まぁ、何にしてもこれで違和感無く操作できるので、練習環境としては出来上がったかなーという所です。合間合間で練習していこうと思います。

余談

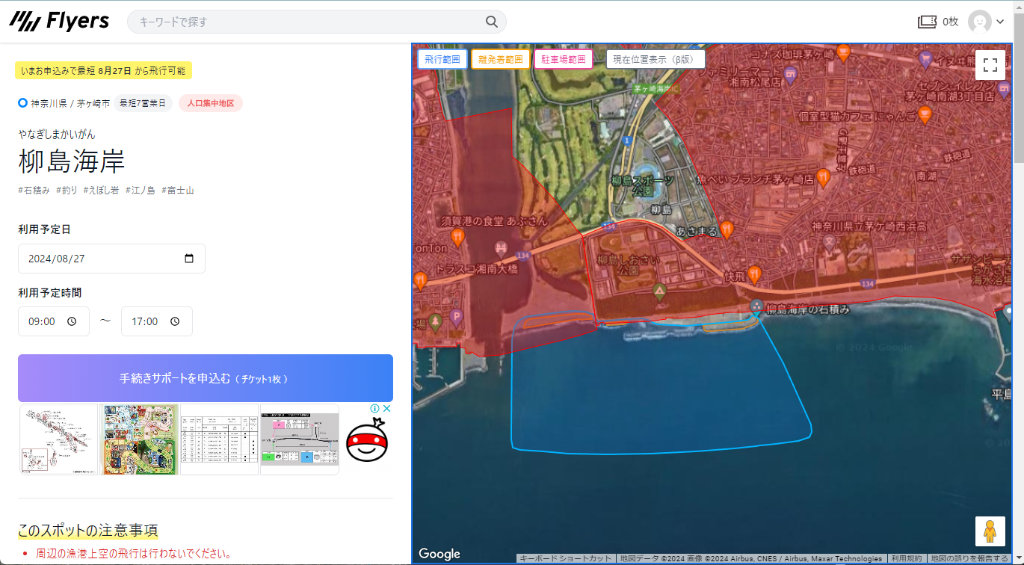

9月の連休中に家族旅行を装って箱根でドローンを飛ばそうと思ってFlyersさんに許可回りお願いしたりしてたんですよね。箱根駒ヶ岳の山頂と箱根スカイラインの中にある箱根芦ノ湖展望公園の2か所を。

で、実際行ってみたら地上は37℃の猛暑日だったらしいですが、芦ノ湖周辺は涼しい風が吹いて26℃くらいと、絶好の観光日和だったのですが、この風が良くなかったらしく箱根駒ヶ岳を昇るロープウェイが強風で運行取りやめに。( エーッ!!

翌日も風速25m吹いたとかでロープウェイが運行する事は無く、では箱根芦ノ湖展望台の方へ…と向かったのですが、箱根スカイラインの入り口辺りから物凄い霧…(-_-;)。まぁ、霧というか雲の中に入っちゃった感じでしょうか。

絶望に打ちひしがれながら辿り着いた展望台は…ここはあの世かサイレントヒルか、みたいな世界が広がっていたのでした…。

ドローン飛ばすのってどんなに意気込んで準備していても、天候の前には一蹴されるんだな…と改めて実感した次第であります…orz。